Hoy, hace 107 años, nace Karl Ludwig von Bertalanffy . El Padre de la Ingeniería de Sistemas.

Fundó junto con otros importantes científicos con visiones sistémicas, la Society for General Systems Research (hoy ISSS).

RECURSOS:

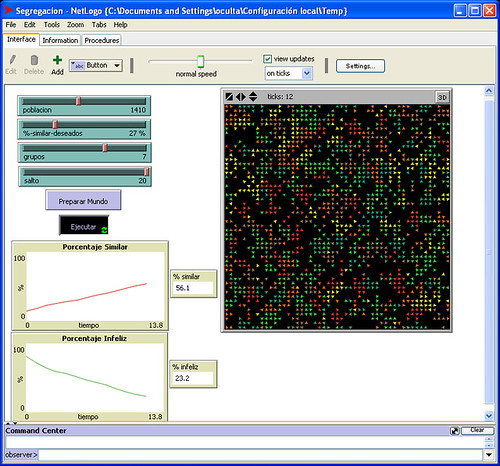

Sistema complejo. Las imágenes fractales son utilizadas para representar el caos en la naturaleza. Mindlin sostiene que el caos se aprecia en fenómenos cotidianos.

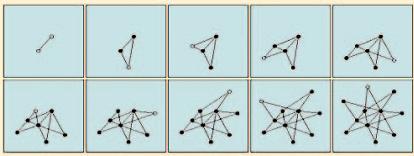

EVOLUCIÓN DE LAS REDES

La emergencia de estructuras de escala libre y de distribución de grado ley de potencias puede ser trazada bajo dos mecanismos. Estos mecanismos están ausentes de los clásicos modelos de grafos aleatorios, y más bien se presentan en varias redes complejas [11]. Primero, los modelos de la teoría de grafos tradicional asumen que el número de nodos en una red es fijo. En contraste, al WWW continuamente se expande añadiendo nuevos sitios web, mientras que la Internet crece con la instalación de nuevos routers, computadoras y vínculos de comunicación. Segundo, mientras que los modelos de grafos aleatorios asumen que los vínculos están aleatoriamente distribuidos, la mayoría de redes reales exhiben una preferencia adjunta. De hecho, es más probable que una persona enlace páginas web a documentos altamente conectados en la WWW, cuya existencia es harto conocida. Los motores de la red además tienden a conectar las computadoras de sus instituciones a través de nodos de gran ancho de banda, los cuales inevitablemente atraerán a otros consumidores y links.

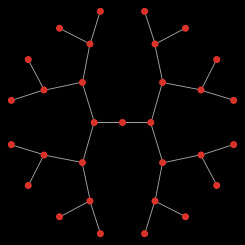

Basados en el número creciente de nodos así como en la preferencia adjunta, se ha considerado un modelo simple en el cual un nuevo nodo es añadido a la red en cada instante de tiempo [11]. EL nuevo nodo luego es vinculado a alguno de los nodos ya existentes en el sistema (Figura 3). La probabilidad Π(k) que un nuevo nodo conecte a un nodo con k links sigue una regla de preferncia adjunta tal como:

Π(k)=k / (Σ ki) ... (2)

donde la suma es sobre todos los elementos de la red. Las simulaciones numéricas indican que la red resultante es de escala libre, y la probabilidad que un nodo tenga k vínculos viene (1) con exponente γ³ [11]. La naturaleza de la ley de potencias de la distribución es predicha por el enfoque basado en la ecuación de razón [19] así como de una solución exacta del modelo de escala libre [20]. Este simple modelo ilustra como el crecimiento y la preferencial adjunta conjuntamente llevan a la aparición de la jerarquía de hub que ejemplifican la estructura de escala libre. Un nodo con más links incrementa su conectividad más rápido que un nodo con menos links, debido a que el ingreso de nodos tiende a conectar a aquellos con mayor probabilidad tal como lo hemos descrito en (2). Este modelo conduce a un fenómeno de retroalimentación positivo de riqueza-a-ricos, el cual es evidente en algunos sistemas competitivos.

EL TALÓN DE AQUILES DEL INTERNET

Como la economía mundial ha vuelto crecientemente dependiente de Internet, surge una preocupación acerca de si la funcionalidad del Internet puede mantenerse aún bajo fallas y ataques hackers. Internet ha probado ser remarcadamente resilente contra fallos. Aunque alrededor del 3% de los routers están típicamente caídos en momentos particulares, nosotros raramente observamos disrupciones mayores en Internet. ¿Cómo Internet se puso tan robusta? Mientras significativa tolerancia al error se construyen en los protocolos que gobiernan las comunicaciones de “pasos de paquetes”, la topología de escala libre del Internet además juega un rol crucial en hacer esto más robusto.

Figura 3 El nacimiento de una red de escala libre. La topología de escala libre es una consecuencia natural de la naturaleza expansiva de las redes reales. Comenzando de dos nodos conectados (arriba a la izquierda), en cada panel un nuevo nodo, el cual sem muestra como un punto abierto, es añadido a la red. Al decidir donde vincularse, nuevos nodos prefieren adjuntarse a los nodos más conectados. Gracias al crecimiento y a la adjunta preferencial, emergen unos pocos hubs altamente conectados. Después [1].

El concepto de percolación provee un enfoque para el entendimiento de la tolerancia al error inducida por la escala libre del Internet. La teoría de percolación especifica que la remoción aleatoria de nodos de una red da como resultado una transición de percolación inversa, cuando una fracción crítica fc de nodos es removida, los fragmentos de red sobrantes no comunican las islas de nodos. Sin embargo, simulaciones de redes de escala libre no apoyan las predicciones de la teoría de percolación [21]

P(k) ~ k – γ, (1)

Donde γout ≈ 2.45 (γin ≈ 2.1).

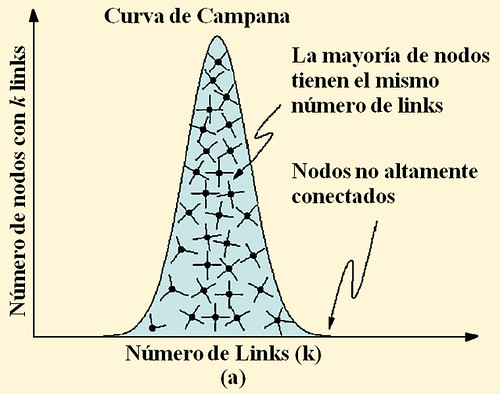

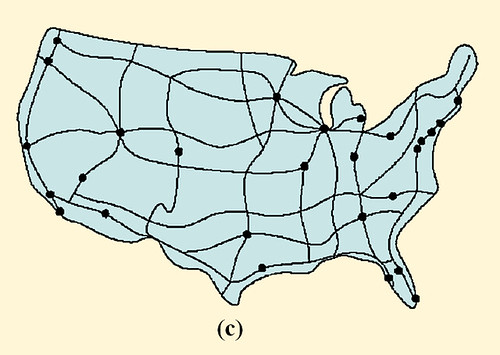

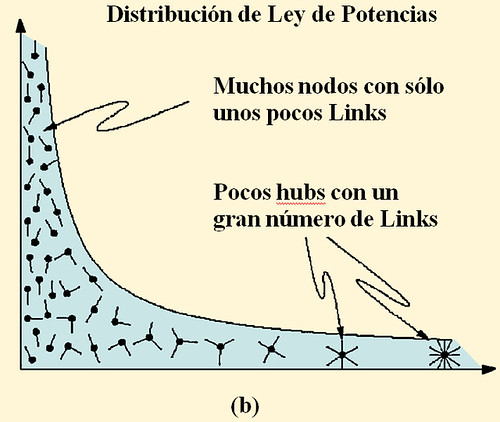

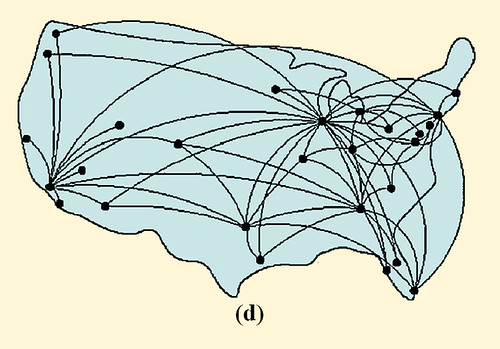

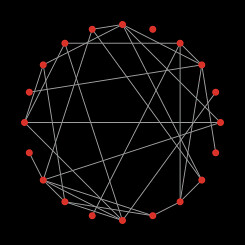

FIGURA 1 Redes Aleatorias y de escala libre. El grado de distribución de una red aleatoria sigue la distribución de Poisson cerrada con la forma de una curva de campana, diciéndonos que casi todos los nodos tienen el mismo número de links, y que los nodos con un gran número de links no existen (a). Esto es, una red aleatoria es similar a una red nacional de carreteras en las cuales los nodos son as ciudades y los vínculos son las mayores carreteras que las conectan. De hecho la mayoría de ciudades son conectadas por aproximadamente el mismo número de carreteras (c). en cambio la distribución de grado de ley de potencias de una red de escala libre predice que la mayoría de nodos tienen sólo unos pocos links que se mantienen juntos por muy pocos hubs altamente conectados (b). Tal red es similar al sistema de tráfico aéreo, en el cual un gran número de pequeños aeropuertos están conectados unos a otros mediante unos pocos hubs mayores (d). Luego [1]

Contenido

Prólogo

Isaac Dyner y Luisa Rodríguez

PARTE I: Pedagogía de

1. Introducción al Pensamiento Sistémico. Pensamiento sistémico, un nuevo paradigma

Angélica Martínez

2. Herramientas para la enseñanza de

Samuel Prieto

3. Didácticas en la enseñanza de Dinámica de Sistemas

Martín Schaffernicht

4. "Prosa" sistémica y dinámica como elemento de sensibilización y de cambio de enfoque

Fabián Szulanski

5. Experimentos de laboratorio en Dinámica de Sistemas

Santiago Arango y Erling Moxnes

6. Propuesta para la difusión de

Hugo Andrade y Ximena Vargas

PARTE II: Aplicaciones en educación

7. Gestión universitaria con Dinámica de Sistemas

Lilia Gélvez

8. Dinámica de Sistemas en la medición del emprendimiento

Luisa Rodríguez

9. Dinámica de Sistemas y aprendizaje en contaduría: Una experiencia en el aula.

Jorge Juliao y Ómar Díaz

10.Workshop. Simulador de carrera laboral

Eduardo Fracassi

PARTE III: Aplicaciones en política pública

11. Modelo en Dinámica de Sistemas para gestión socio ambiental

Mauricio Díaz

12. Micromundos en la comercialización de energía en ENERBIZ

Santiago Arango, Isaac Dyner y Carlos Franco

13.Sistema integrado de vigilancia y control de malaria y dengue en Colombia

Daniel Ruiz Carrascal, Stephen Connor y Madeleine Thomson

14. Modelo de gerencia sistémica de activos y pasivos en fondos de pensiones.

Ricardo Matos

15.Tras las estructuras del crimen y la justicia

Sebastián Jaén e Isaac Dyner

PARTE IV: Aplicaciones en estrategia empresarial

16. Cómo hacer estrategia usando Dinámica de Sistemas

Martín Kunc

17. FODA dinámico."Reporte de una página" dinámico

Fabián Szulanski

Estamos rodeados por Sistemas Complejos, desde células hechas por miles de moléculas hasta sociedades, una colección de millones de interacciones individuales. Estos sistemas exhiben señales de orden y auto-organización. El entendimiento y cuantificación de esta complejidad es un gran reto para la ciencia. La teoría cinética, desarrollada a finales del siglo XIX, muestra que las propiedades medibles de los gases, desde la presión hasta la temperatura, pueden ser reducidos al movimiento aleatorio de átomos y moléculas. En los 60's y 70's, investigadores desarrollaron enfoques sistemáticos para cuantificar la transición de desorden a orden en sistemas materiales tales como magnetos y líquidos. La Teoría del Caos dominó la búsqueda por entender el comportamiento complejo en los 80's con el mensaje que el comportamiento impredecible puede emerger de las interacciones no lineales de unos pocos componentes. Los 90's fue la década de los fractales, cuantificando la geometría de los patrones emergentes en sistemas auto-organizados, desde hojas hasta copos de nieve.

A pesar de estos avances conceptuales, no existe aún una teoría de la complejidad completa. Cuando intentamos caracterizar Sistemas Complejos, las herramientas de que disponemos fallan por diversas razones. Primero, los sistemas complejos no están hechos de componentes idénticos tales como los gases y los magnetos. Aún más, cada gen en una célula o cada individuo en una sociedad tiene su propio comportamiento característico. Segundo, mientras que las interacciones entre los componentes son manifiestamente no lineales, verdaderamente el comportamiento caótico es más la excepción que la regla. Tercero, y más importante, las moléculas y las personas no obedecen ni al desorden extremo de los gases, donde cualquier molécula puede colisionar con otra, o al orden extremo de los magnetos, donde los spins interactúan sólo con su vecindad inmediata en una rejilla periódica. Es más, en sistemas complejos, las interacciones forman REDES, donde cada nodo interactúa con sólo una pequeña cantidad de parejas seleccionadas cuyas presencias y efectos pueden ser sentidos en nodos muy lejanos.

Las redes exisen en todos los lugares y en todas las escalas. el cerebro es una red de células nerviosas conectadas por axons, mientras que las células son redes de moléculas conectadas por reacciones bioquímicas. Las sociedades, también, son redes de personas vinculadas por amistad, familia, y lazos profesionales. A una gran escala, redes de alimentos y ecosistemas se pueden representar como redes de especies. Por otro lado, las redes invaden la tecnología; como ejemplos tenemos la Internet, redes de energía eléctrica y los sistemas de transportes. Aún el lenguaje usado para transmitir pensamientos es una red de palabras conectadas por relaciones sintácticas.

A pesar de la pervasividad de las redes, sin embargo, su estructura y propiedades aún no son totalmente entendidas. Por ejemplo, los mecanismos mediante los cuales genes disfuncionales en una red genética compleja llevan a la producción del cáncer no es obvia, y la difusión rápida a través de redes sociales y de comunicación que llevan alas epidemias de enfermedades y los virus de computadotas aún no son bien caracterizados. Además, es importante entender cómo algunas redes continúan funcionando a pesar de fallas en la mayoría de sus nodos.

Investigaciones recientes están empezando a responder tales preguntas [1]-[6]. Hace unos pocos años los científicos han descubierto que las redes complejas tienen una arquitectura subyacente guiada po prinipios universales. Por ejemplo, muchas redes, desde la world wide web (www), los sistemas metabólicos de las células, hasta los actores de Hollywood, son dominados por un pequeño número de nodos que están altamente conectados a otros nodos. Estos nodos importantes llamados hubs, afectan en gran medida el comportamiento total de las redes. Como describimos en este artículo, os hubs hacen a las redes robustas contra fallas accidentales pero vulnerables a ataques coordinados.

(continua...)

Una red es una descripción de las conexiones que permiten las interacciones e influencias entre las partes de un sistema complejo. Además se usa para referirse a las partes junto con su conexiones, i.e. los sistemas como totalidad, cuando consideramos los efectos de esas conexiones.

Hay varios tipos de redes:

redes de transporte - las carreteras de una ciudad,

redes de comunicación - la red telefónica,

redes de servicio público - la malla de potencia eléctrica de un país.

redes de abastecimiento - el sistema de abastecimiento de alimentos en una ciudad,

redes de reacciones moleculares - redes metabólicas,

redes de células - redes neuronales,

redes de computadoras - internet, y

redes sociales - la gente en una empresa, o en una comunidad.

Una propiedad importante de las redes es su topología: i.e. cuáles elementos están directamente relacionados con cuáles otros. Entonces , pueden discutirse propiedades más específicas de las conexiones. Cada conexión de lared puede ser caracterizada por propiedades tales como su rango de influencia, capacidad, etc.

Todas las redes pueden ser pensadas como redes de influencia: el estado de las partes que están conectadas a una red afectan a los otros a través de la red. Conceptualmente podemos distinguir entre redes que transfieren materiales (abastecimiento, transporte, servicios públicos, químicos), y redes que transfieren información (neuronas, comunicación, computadoras, sociales).

La manera en que pensamos las redes a menudo depende de cuan complejo sea el comportamiento de la red misma. Por ejemplo, a menudo pensamos en el sistema de transporte como una red en sí misma, a pesar que es una red que se conecta al sistema socioeconómico. En este caso pensamos en los atascos de tráfico y no acerca del rol de las carreteras como conectores. En otros casos nosotros nos enfocamos en cómo se comportan las partes como resultado de sus conexiones a través de la red, o cómo el sistema, como un todo, se comporta debido a las partes de la red.

En muchas de las redes más comúnmente estudiadas se asume que éstas están conectadas a partes similares, con conexiones que son en cierto sentido similares. Por lo tanto la atención se centra sólo en la topología de la red que caracteriza este comportamiento. Sin ebargo, de modo más general, las redes reales conectan partes disímiles en distintos modos.

Como parte del estudio de sistemas complejos, el entendimiento general que nosotros obtenenos de como se comportan las redes puede ser transferido entre varios tipos de sistemas, si son físicos, biológicos, sociales o de ingeniería. Es útil pensar acerca de los comportamientos que son comunes a diferentes tipos de redes, y los que son diferentes.

Principios fundamentales a seguir en la Ingeniería de Sistemas (IS):

Observación, consideración "holística"

La IS, es metodología "holística" (del griego, "holos"=todo): debe estructurar el tratamiento racional de problemas, o de los métodos para su solución, de tal forma que se tengan en cuenta "todos" los factores influyentes en la situación de problema.

En general, un enfoque de la IS difiere del tratamiento convencional de problemas en cuanto a su "generalidad", en su base lógica o mental, y en su búsqueda de los principios o factores más universales que puedan haber contribuído a provocar la situación-problema analizada.

La SE, como la Teoría general de Sistemas, parte del principio de que un sistema es construido como autoconfigurado y autodelimitado frente a su entorno, por "reducción selectiva de complejidad" conseguida desde el mismo sistema, y mantenida en su permanente auto-referencia y auto-reproducción ("autopoiesis").

El grado de complejidad de un sistema es siempre menor que el de su entorno. Esa complejidad se concreta en las relaciones entre las áreas de problemas, una empresa, p.ej., la reduce al seleccionar un segmento de mercado con determinadas necesidades a satisfacer.

En el marco de la actividad empresarial de “creación de valor”, la INNOVACIÓN constituye quizá la actividad más importante (la que según Schumpeter constituía realmente la característica distintiva del Empresario-Emprendedor). Ahora bien, en la evolución del planteamiento de la ingeniería de sistemas era lógico que al querer extenderla a nuevos campos de trabajo hubiera que plantearse el tema de la innovación (en el dominio estudiado, es decir, en el campo de objetos) y el tema del aprendizaje del equipo o sistema-activo que realiza la configuración o ingeniería del sistema-solución.

El modelo básico de la “máquina cibernética” (como “máquina trivial”) era realmente inadecuado pues el “regulador” con las magnitudes-meta que sirven para controlar los flujos de inputs desde la medición del flujo de outputs es independiente de la situación del entorno. Por eso es preciso pasar a un modelo de “doble bucle” en que esas mismas magnitudes de control sean modulables según el entorno y los mismos inputs. Von Foerster utilizó el modelo de la “máquina de Turing” para desarrollar su “máquina no trivial” en que los outputs (soluciones a los problemas planteados) no sólo serán ya resultado de la “transformación” de inputs en un primer circuito cibernético, sino también dependerán de que las magnitudes de control de ese primer sistema productor de solucioines sea modulado por un segundo sistema (el sistema observador) inserto también en el mismo entorno y sometido a los mismos flujos de inputs. Ese sistema superior (sistema observador y activo) deberá pues ser capaz de “aprender”, es decir, ser capaz de manejar nuevas magnitudes (en orden a definir nuevos objetivos y metas, y también nuevos criterios o magnitudes de control). Los outputs de este sistema superior – que han de ser los que controlen el sistema-objeto en configuración – se configuran pues como resultado de su actividad (resultante de haber “aprendido”), una actividad que – en forma paralela a la de la configuración del sistema-objeto a la que denominamos “ingeniería” – se denomina “imaginería” (“Imagineering”).

El término debe formular la idea de que el proceso de la configuración del futuro (del sistema-objeto solución) implica un “des-aprender” contenidos tradicionales, y un “aprender” creativo de nuevos conceptos etc. (Hamel/Prahalad 1994 [1]).

El sistema activo no puede permanecer anclado en una estructura fija, sino él mismo deberá evolucionar “aprendiendo” en interacción continua con el campo de problemas analizado en que se configura (en ingeniería activa) el sistema solución. Tal aprendizaje deberá concentrarse en las competencias clave (¡Gestión del conocimiento!).

Temporalidad: principio de la consideración dinámica- evolucionista

Se trata de no olvidar la dimensión temporal, y de flujo de las situaciones-problema. La IS impone como principio metodológico no restringir la consideración de ningún problema al punto temporal del presente, es decir, superar la visión estaticista para llegar a ver toda situación problema en su dimensión de flujo temporal.

La IS considera los sistemas-objeto como algo dinámico, como algo donde ocurren eventos. El "modelo" construído en el sistema-configurador tendrá que poder representar al sistema-objeto como secuencia de estados distintos en dependencia del tiempo. La variabilidad temporal del sistema se refiere a:

- los tipos e intensidades de las relaciones entre el sistema y el entorno

- los tipos e intensidades de las relaciones en el interior del sistema

- las mismas propiedades de los elementos del sistema

- la misma estructura u ordenamiento mutuo de los elementos del sistema.

Sólo en esta apertura a lo nuevo se crea la base para realizar una ingeniería de sistemas que incluso cree mercados futuros.

Principio de la estructuración (jerárquica o en redes) de sistemas:

La IS, como la Teoría de Sistemas, parte del supuesto de que la mayoría de los sistemas se configuran en su tratamiento y reducción de la complejidad mediante la "interpenetración" de subsistemas (antes se hablaba de "partes") que a su vez reducen externa a ellos y crean complejidad interna. En atención a la estructuración interna del sistema-2 (sistema-objeto) en subsistemas, y en atención a las capacidades del subsistema cognitivo, la IS propone que todo método de solución de problemas complejos realice una división (análisis) de la temática a estudiar, y que la estructure (síntesis).

Este trabajo debe realizarse por diferenciación progresiva, por aumento del grado de detalle en el estudio de los objetos tratados.

Aunque el trabajo de estructuración tradicionalmente siguió el procedimiento de desglose "jerárquico" (por ejemplo, en estructuras arborescentes, como el árbol de funciones en el primer Value Analysis), hoy se trabaja en desgloses en "networks" (la técnica del "hypertext", por ejemplo) que además mantienen entre sus nudos relaciones no deterministas (según el concepto lógico de los conjuntos difusos - fuzzy sets).

Exigencia de la "reducción de complejidad"

La metodología de la IS impone "delimitar" - por diferencia frente al entorno - el ámbito del problema a elaborar. Esa delimitación implica dejar fuera del campo de estudio ciertos aspectos, los considerados menos relevantes, y destacar otros factores. Se pide a los métodos concretos que ayuden a realizar esta selección: p.ej. como en el Pareto, o ABC. Asimismo se pide distingan síntomas aparentes de causas o factores profundos. También se debe delimitar el campo de lo "factible" frente al de lo "utópico". En esta delimitación se pide se cumpla la racionalidad de la "aurea mediocritas" (evitar la "hybris" o el exceso): hasta el mismo cumplimiento excesivo de la norma jurídica puede llevar a vulnerar la norma de justicia ("summum ius, summa iniuria" - máxima legalidad, máxima injusticia).

Diferenciar entre Sistema Configurador y Sistema Objeto

La metodología normativa de la solución de problemas en la IS exige la constitución de un "sistema-configurador" o sistema-acción (que abarque la situación concreta y sus entornos, incluyendo el o los sujetos encargados del tratamiento de problemas. Un ejemplo de tal creación de sistema de solución de problemas considerados desde un enfoque común se encuentra en la formación de un "proyecto" (de AV, etc.) o en la creación de una "transfunción" como la del "Controlling" o la "Logística". Crear un sistema implica trazar sus límites frente al entorno.

La metodología de la IS impone además delimitar - por diferencia frente al entorno - el ámbito del problema a elaborar. Esa delimitación implica dejar fuera del campo de estudio ciertos aspectos, los considerados menos relevantes, y destacar otros factores. Se pide a los métodos concretos que ayuden a realizar esta selección: p.ej. como en el Pareto, o ABC. Asimismo se pide distingan síntomas aparentes de causas o factores profundos. También se debe delimitar el campo de lo "factible" frente al de lo "utópico". En esta delimitación se pide se cumpla la racionalidad de la "aurea mediocritas" (evitar la "hybris" o el exceso): hasta el mismo cumplimiento excesivo de la norma jurídica puede llevar a vulnerar la norma de justicia ("summum ius, summa iniuria" - máxima legalidad, máxima injusticia).

[... un sistema, cualquiera sea este, surge en el momento en que en un conjunto de elementos comienza a conservarse una dinámica de interacciones y de relaciones que dan origen a un clivaje operacional que separa a un subconjunto de esos elementos que pasa a ser un sistema, de otro elementos que quedan excluidos de éste y que pasan a ser el entorno. La dinámica de interacciones y relaciones que como configuración relacional entre elementos al conservarse separa a un conjunto de elementos de otros dando origen a un sistema, pasa a ser la organización del sistema, en tanto que el conjunto de elementos y relaciones que realizan esta organización en la unidad operacional que surge así separada de un medio como un ente particular, pasa a ser la estructura.]

El cibernetista británico W. Ross Ashby propuso lo que llamó “el principio de autoorganización”. El notó que un sistema dinámico, independientemente de su tipo o composición, siempre tendía a evolucionar hacia un estado de equilibrio, o lo que podríamos ahora llamar un atractor. Esto reduce la incertidumbre que tenemos acerca del estado de sistema, y por consiguiente la entropía estadística del sistema. Esto es equivalente a la auto-organización. El equilibrio resultante puede ser interpretado como un estado donde las diferentes partes de sistema están mutuamente adaptadas.

La auto-organización es básicamente la creación espontánea de patrones coherentes globalmente provenientes de interacciones entre componentes inicialmente independientes. Este orden colectivo está organizado en función de su propio mantenimiento, y de este modo tender a resistir perturbaciones. Esta robustez se logra con el control distribuido y redundante de modo que cualquier daño pueda ser restaurado por las secciones restantes no dañadas.El mecanismo básico subyacente a la auto-organización es la variación determinista o estocástica que gobierna cualquier sistema dinámico, explorando diferentes regiones en el espacio de estados hasta que cae en un atractor, i.e. a una configuración que se cierra en sí misma. Este proceso puede ser acelerado y profundizado por el incremento de variación, por ejemplo por adición de “ruido” al sistema. La entrada a un atractor impide futuras variaciones fuera del atractor, y por lo tanto, restringe la libertad de los componentes del sistema de comportarse independientemente. Esto es equivalente al incremento de coherencia, o disminución de la entropía estadística, que define la auto-organización.La clausura define al sistema separado de su entorno, definiéndolo como autónomo. La clausura usualmente es el resultado de la naturaleza retroalimentada y no lineal de las interacciones. Si la retroalimentación es positiva llevará a un crecimiento explosivo de cualquier configuración originalmente que entra en el régimen de retroalimentación positiva. Este crecimiento acaba cuando todos los componentes disponibles han sido absorbidos en una nueva configuración, dejando al sistema en un estable estado de retroalimentación negativa.

La teoría de auto-organización tiene muchas aplicaciones potenciales -pero aún relativamente poco prácticas- En principio ofrece una visión del funcionamiento de la mayoría de sistemas complejos que nos rodean, desde galaxias y planetas hasta moléculas, y desde células vivas a ecosistemas y mercados. Tal entendimiento sin embargo no necesariamente lleva a una mejor capacidad de predicción, debido a que el comportamiento de los sistemas auto-organizados es impredecible por su propia naturaleza. Por otro lado, obtener una mejor comprensión de las fuentes relevantes de selección, la variación y las estructuras intrínsecas de un atractor nos ayudarán a conocer cuáles comportamientos son posibles y cuáles son imposibles.

Aceptamos dos tipos de trabajos:

Los artículos en extenso serán sometidos a revisión anónima por parte de dos árbitros y que – de ser aceptados – serán publicados en las Actas del Congreso. Los revisores pueden recomendar la publicación en el número especial de la Revista de Dinámica de Sistemas.

Los trabajos deben ser redactados en español, portugués o inglés. Todo trabajo sometido requiere un presentador principal inscrito hasta una fecha límite; trabajos sin este respaldo se eliminarán del programa.

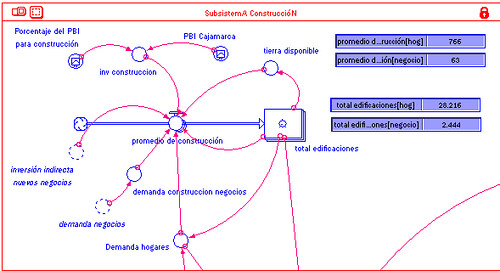

Para los artículos que reportan de trabajos de modelamiento, es altamente deseable agregar el modelo o, en su defecto, las ecuaciones como material adicional. Los mejores artículos serán considerados para su publicación en la revista de Dinámica de Sistemas.

Los posters con resumen extendido son una modalidad especial para autores que no podrán asistir al congreso. Los resúmenes extendidos (4 páginas) serán sometidos a la evaluación del comité de programa y expuestos como posters durante el Congreso, pero no publicados en sus Actas, donde solamente se incluirá el listado de autores de “poster”. Los “posters” se encontrarán en determinadas zonas visibles durante la extensión del congreso. Para esta modalidad rige la tarifa especial de US$20.

Martin Schaffernicht, Universidad de Talca

martin@utalca.cl

Martín Kunc, Universidad Adolfo Ibañez

martin.kunc@uai.cl

Juan Pablo Torres, Universidad Diego Portales

jpablo.torres@udp.cl

>>>>>>>>>>>MÁS INFORMACIÓN AQUÍ<<<<<<<<<<<<<

Un primer acercamiento a esta cuestión que suele ser un tanto confusa nos lleva a definiciones básicas de ambos términos. Desde un primer repaso diremos que información son datos estructurados y que conocimiento es información en acción. Pero vayamos un poco más lejos. Si recordamos las jerarquías (WUKID: Windsom Sabiduría, Understanding Entendimiento, Knowledge Conocimiento, Information Información, Data Dato) de Russell Ackoff:

Elizabeth Orna en Making Knowledge Visible: Communicating Knowledge Through Information Products describe el proceso mediante el cual la información se transforma en conocimiento y viceversa. Afirma que la información vive en el exterior, conde se hace visible y disponible para los otros y es capaz de alimentar su conocimiento, pero el conocimiento no es algo que yo pueda dar a otra persona, porque la información tiene que ser transformada en algo que sólo vive en la mente humana. En general estamos invisible y constantemente transformando información en conocimiento y de nuevo en información para que otros la puedan consumir. El diagrama de esta transformación según Orna se puede ver en el slide 2 de una presentación que di en el Instituto de verano de KM.

Lackoff y Johnson en Metaphors We Live By y Philosophy in the Flesh fueron más allá en sus distinciones entre información y conocimiento reclamando que el conocimiento solo resulta cuando tenemos un cuerpo físico que puede sentir y actuar en el mundo.

Aquí algunos links adicionales

Workshops

I

Reconstruccion de dinamicas de comunidades cientificas: un ejemplo de la cognicion socialPor confirmar (P)

Emergencia es...

...Lo que juntas hacen las partes de un sistema y que ellas no podrían hacer por sí mismas: comportamiento colectivo.

...Lo que un sistema hace en virtud de su relación con su medio ambiente, y que este no podría hacer por sí mismo: ejm. su función.

... El acto o proceso de convertirse en un sistema emergente.

De acuerdo con (1) emergencia se refiere al entendimiento de cómo las propiedades colectivas surgen de las propiedades de las partes. En general se refiere a como el comportamiento a gran escala de los sistemas proviene de lo detalles de su estructura, comportamiento y relaciones en una escala menor. En el extremo es cómo el comportamiento macroscópico proviene del comportamiento microscópico.

De acuerdo a esta visión, cuando pensamos en emergencia nosotros estamos, a los ojos de nuestra mente, moviéndonos entre diferentes puntos de vista, Vemos los árboles y el bosque al mismo tiempo. Vemos el modo en que los árboles y el bosque están relacionados el uno con el otro. Para ve en ambos puntos de vista tenemos que ser capaces de ver los detalles, pero además ignorar los detalles. El truco está en saber cuáles de los muchos detalles que vemos en los árboles son importantes para saber cuando estamos viendo el bosque.

La visión del observador convencional considera o los árboles o el bosque. Quienes sólo consideran los árboles consideran que los detalles son lo esencial y no ven los patrones que que surgen cuando consideramos los árboles en el contexto del bosque. Quienes consideran al bosque no ven los detalles. Cuando uno se puede desplazar hacia adelante y hacia atrás entre la vista de los árboles y el bosque uno puede además ver que aspectos de los árboles son relevantes para la descripción del bosque. El entendiendo de esta relación, en general, es el estudio de la emergencia.

Un ejemplo útil es una llave. Una llave tiene una estructura particular. Para describir su estructura no es suficiente decirle a alguien que esta puede abrir una puerta. Nosotros tenemos que saber ambas cosas, la estructura de la llave y de la cerradura. Sin la descripción de la estructura de cualquiera de ellos, sin embargo, podemos decirle a alguien que esta puede destrabar la puerta.

Uno de los problemas en la forma de pensar en los conceptos de sistemas complejos es que a menudo nosotros asignamos propiedades a un sistema que no son si no propiedades de una relación entre el sistema y su entorno. ¿Por qué hacemos esto? Porque nos hace pensar en lo que ocurre de modo más simple. ¿Por qué podemos hacer esto? Porque cuando el entorno no cambia entonces sólo necesitamos describir el sistema y no el entorno para dar la relación. Así, la relación está muchas veces implícita en lo que decimos y pensamos.

El segundo aspecto de emergencia (2) está relacionado al primer aspecto (1) porque el sistema puede ser visto con partes de su entorno así juntos formando un sistema mayor. El comportamiento colectivos debido a las relaciones de las partes del sistema mayor reflejan las relaciones del sistema original con su entorno.

Los roles de las relaciones:

El rol de los patrones:

La idea de emergencia es contrastada muchas veces con la perspectiva reduccionista. La perspectiva reduccionista piensa en las partes de manera aislada. Esta es la muchas veces vilipendiada visión del mundo de “sistemas anti-complejos”. Sin embargo, aún la idea de “sistema” esta basada en un reduccionismo parcial. para entender esto uno debería entender cuidadosamente la noción de aproximación o “verdad-parcial” la cual es esencial para el estudio de los sistemas complejos.